· LLM

Model Context Protocol - czym jest i jak działa?

TL;DR

Model Context Protocol to otwarty standard integracji LLMów ze światem zewnętrznym. Składa się z trzech kluczowych elementów: hosta, klienta i serwera. W tym artykule omawiamy kluczowe składowe całego projektu.

Integracja AI ze światem zewnętrznym

W świecie, gdzie usługi oparte o modele językowe stają się nieodłącznym narzędziem każdego pracownika umysłowego, potrzeba płynnej integracji LLMów z różnorodnymi źródłami danych i wewnętrznymi systemami staje się kluczowa.

Przed pojawieniem się protokołu Model Context Protocol (MCP), każda taka integracja wymagała budowania dedykowanych rozwiązań dla konkretnej kombinacji modelu i zewnętrznego komponentu, co prowadziło do trudnego w utrzymaniu problemu “M (modeli) × N (komponentów)”. Skutkowało to rosnącą liczbą niekompatybilnych rozwiązań, które trzeba było rozwijać i aktualizować dla każdego nowego scenariusza z osobna.

W tym artykule przyjrzymy się rozwiązaniu tego problemu w postaci MCP - poznamy jego architekturę, zrozumiemy przewagę nad istniejącymi standardami oraz powody rosnącej adopcji w branży technologicznej.

Geneza MCP - Potrzeba jednego standardu

Model Context Protocol narodził się jako odpowiedź na rosnącą potrzebę płynnej integracji modeli językowych z zewnętrznymi elementami, do których domyślnie modele nie mają dostępu. Mimo ogromnego potencjału, nawet najbardziej zaawansowane modele AI pozostawały “odcięte” od aktualnych danych - zamknięte w silosach informacji treningowych, z ograniczonym dostępem do plików, baz danych czy API.

Dotychczasowe podejście, polegające na tworzeniu dedykowanych wtyczek lub API dla każdej kombinacji aplikacji i źródła danych, było trudne do skalowania. Aby połączyć M-modeli/agentów z N-systemów, potrzebne było M×N unikatowych integracji - zgodzimy się, że była to sytuacja daleka od optymalnej.

MCP powstał jako uniwersalny, otwarty standard dla połączeń między LLM a światem zewnętrznym. Porównywany do “USB-C dla świata AI”, MCP umożliwia modelom dostęp do aktualnych danych, wykonywanie akcji i korzystanie z narzędzi poprzez jednolity interfejs komunikacyjny.

Co istotne, rozwój MCP rozpoczął się w 2024 r. z inicjatywy firmy Anthropic (twórcy modeli Claude), ale od początku myślą przewodnią było utworzenie prawdziwie otwartego i powszechnie akceptowanego standardu - nie tylko na własne potrzeby. Anthropic kierował się filozofią “dogfoodingu” - zanim ogłoszono standard publicznie, rozbudowano go i przetestowano wewnętrznie na własnych projektach, co sprawiło, że MCP zadebiutował jako sprawdzony w praktyce protokół z gotowym ekosystemem.

Architektura Model Context Protocol

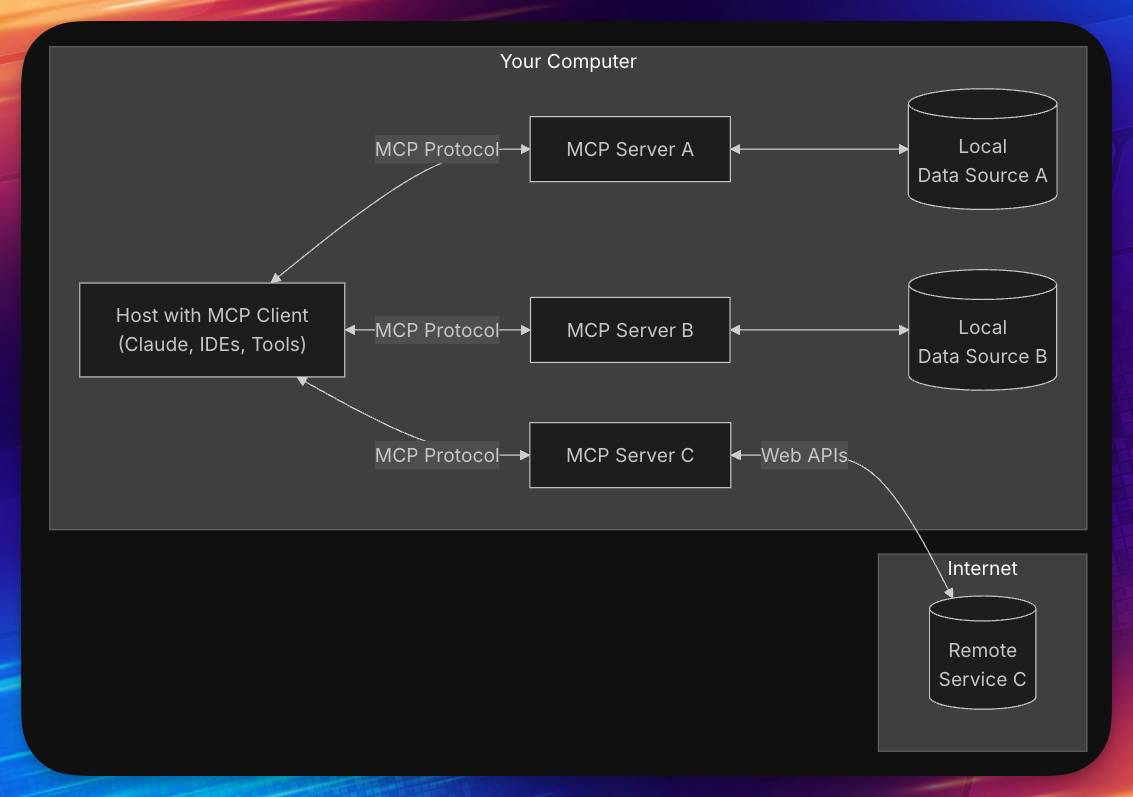

MCP opiera się na wzorcu komunikacji stanowej klient-serwer, mediowanym przez hosta (np. aplikację desktopową). Kluczowe elementy tej architektury to:

1) Host

To aplikacja AI lub agent (np. Claude Desktop, VS Code z Copilotem, Cursor, Windsurf), która:

- inicjuje i zarządza sesjami MCP

- agreguje odpowiedzi z różnych serwerów

- prezentuje użytkownikowi interfejs do zatwierdzania akcji i przeglądania dostępnych narzędzi

- odpowiada za polityki bezpieczeństwa i kontrolę uprawnień

2) Klient

Każdy klient jest komponentem osadzonym wewnątrz hosta:

- utrzymuje 1:1 połączenie z pojedynczym serwerem MCP

- prowadzi negocjację możliwości (capabilities) w fazie initialize/initialized

- tłumaczy wywołania modelu na komunikaty JSON-RPC i z powrotem zwraca wyniki serwera

3) Serwer

Serwer MCP to lekka usługa (lokalna lub zdalna), która:

- eksponuje narzędzia (tools) – funkcje wywoływalne przez model

- udostępnia zasoby (resources) – dane tylko-do-odczytu

- rejestruje prompty (prompts) – predefiniowane szablony interakcji

Całość współpracuje tak jak na poniższym diagramie:

(Źródło: Model Context Protocol)

Architektura MCP wykorzystuje trzy kluczowe prymitywy:

-

Tools (narzędzia) – wywoływalne funkcje, które model może samodzielnie zainicjować. Stanowią odpowiednik function calls dla LLM. Są kontrolowane przez model (model-controlled) – to AI wybiera moment i sposób ich użycia w trakcie konwersacji.

-

Resources (zasoby) – dane kontekstowe, typowo tylko do odczytu, które MCP udostępnia modelowi. Kontrolę nad resources sprawuje aplikacja/host (application-controlled) – to środowisko decyduje, jakie zasoby i w jakiej formie są widoczne dla modelu.

-

Prompts (szablony/polecenia) – predefiniowane wzorce interakcji albo dodatkowe komunikaty, które mogą być wstawione do rozmowy. Kontrolę nad prompts ma użytkownik (user-controlled) – wywołuje się je świadomie, zwykle w formie komendy lub przycisku w interfejsie.

Przewagi MCP nad OpenAPI i LSP

MCP został zaprojektowany jako standard integracji “AI-native”, czyli taki, który od podstaw uwzględnia specyfikę pracy agentów AI i modeli językowych. W przeciwieństwie do istniejących rozwiązań (jak OpenAPI czy GraphQL), stworzonych głównie z myślą o tradycyjnych aplikacjach i usługach webowych, MCP skupia się na scenariuszach konwersacyjnych z udziałem LLM.

Kluczowe przewagi MCP to:

Stanowość i kontekstowość

MCP został zaprojektowany jako protokół połączeniowy utrzymujący stan – klient i serwer najpierw się inicjalizują i negocjują możliwości, a potem mogą wymieniać wiele powiązanych komunikatów w ramach jednej sesji. To duża różnica w porównaniu z REST/OpenAPI, gdzie każde wywołanie jest niezależne i bezstanowe.

Semantyka dla AI

W MCP semantyka wbudowanych prymitywów odzwierciedla typowe potrzeby LLM: zamiast setek niskopoziomowych metod HTTP, mamy kilka kategorii integracji (tool/resource/prompt), co jest bardziej zrozumiałe dla modelu. OpenAPI, chociaż czytelne i sprawdzone w praktyce, jest zbyt granularne – nie oddaje koncepcji specyficznych dla AI, takich jak intencjonalny podział na narzędzia czy zasoby.

Inspiracja z LSP

LSP (Language Server Protocol) był ważną inspiracją dla MCP. Oba standardy dzielą filozofię odseparowania implementacji funkcjonalności od aplikacji klienckiej. Różnice między standardami wynikają z obszaru zastosowań - LSP jest bezstanowe i dotyczy tylko tekstu/kodu, natomiast MCP musi obsłużyć konwersację z modelem, wykonywanie akcji i dostęp do potencjalnie wrażliwych danych.

Adopcja i momentum MCP

Od upublicznienia protokołu MCP (końcówka 2024) jego adopcja nabrała imponującego tempa, napędzana zarówno przez wiodących dostawców AI, jak i entuzjastyczną społeczność developerów:

-

Anthropic jako autor specyfikacji i główny promotor standardu, firma otworzyła cały projekt jako open-source i zachęciła innych do wspólnego rozwoju.

-

OpenAI oficjalnie ogłosiło dodanie obsługi MCP w swoich produktach, w tym w aplikacji ChatGPT Desktop - zamiast forsować własny standard, zdecydowało się przyjąć protokół zaproponowany przez konkurenta.

-

Google również dołączyło do inicjatywy MCP, ogłaszając implementację protokołu w modelach Google Gemini i odpowiednich SDK.

Fakt, że trzech największych graczy AI (Anthropic, OpenAI, Google) wspólnie wspiera jeden standard, dał MCP ogromny kredyt zaufania i zapewnił zasoby potrzebne do dynamicznego rozwoju.

MCP w edytorach AI

MCP został szeroko zaadoptowany przez czołowych dostawców edytorów AI:

-

Cursor (v0.50+) – Posiada pełną integrację z MCP, głównie w zakresie narzędzi (tools). Połączenie z serwerem MCP może być realizowane zarówno lokalnie (STDIO), jak i przez SSE (zdalny serwer).

-

Windsurf (Wave 7) – Windsurf (dawniej Codeium) oferuje przyjazny interfejs do dodawania serwerów MCP, z listą proponowanych integracji (np. Figma, Slack, Stripe, GitHub, Postgres, Playwright).

-

GitHub Copilot (Agent Mode w VS Code) – Microsoft zdecydował się postawić na MCP jako warstwę integracyjną z dodatkowymi narzędziami. VS Code zawiera wbudowany klient MCP powiązany z Copilotem.

-

Jetbrains AI Assistant - od wiosny 2025 oferuje natywne wsparcie dla Model Context Protocol.

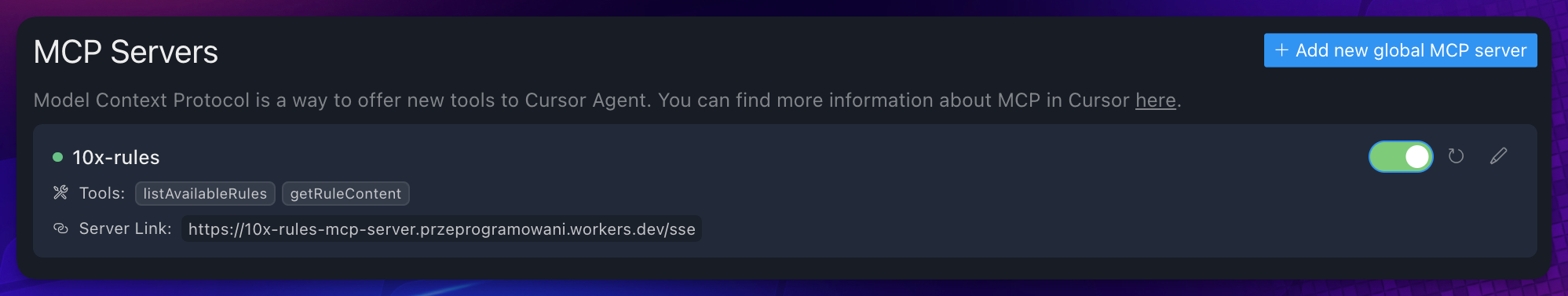

MCP na przykładzie 10xRules.ai

Możliwości MCP możesz przetestować na przykładzie rozwijanego przez nas projektu 10xRules.ai katalogującego reguły, które AI może wykorzystywać w preferowanych przez programistę technologiach.

Nasza usługa została niedawno rozbudowana o dedykowany serwer MCP, który umożliwia pobieraniu reguł bez wychodzenia z edytora lub narzędzia wspierającego MCP.

Serwer MCP oferuje dwa główne narzędzia:

- listAvailableRules - wyświetla listę dostępnych reguł

- getRuleContent - pobiera zawartość wybranej reguły

Aby skorzystać z serwera MCP, powinieneś dodać nasz endpoint do konfiguracji MCP w aplikacji hosta (np. Cursor, Windsurf, VS Code z Copilotem).

- Dla aplikacji wspierających natywnie tzw. Server-Sent Events (SSE), np. Cursor, wystarczy dodać nasz endpoint do konfiguracji MCP:

{

"mcpServers": {

"10x-rules": {

"url": "https://10x-rules-mcp-server.przeprogramowani.workers.dev/sse"

}

}

}- Dla aplikacji wymagających dodatkowego proxy (np. Claude Desktop) skorzystaj z narzędzia

mcp-remote:

- Instalacja globalna:

npm install -g mcp-remote - Konfiguracja w pliku konfiguracyjnym aplikacji hosta:

{

"mcpServers": {

"10x-rules": {

"command": "npx",

"args": [

"mcp-remote",

"https://10x-rules-mcp-server.przeprogramowani.workers.dev/sse"

]

}

}

}Dzięki tej integracji preferowany przez ciebie model “nauczy się” oczekiwanych reguł programowania w najpopularniejszych technologiach, które wystawiamy na świat w ramach projektu 10xRules.ai.

Ekosystem serwerów MCP

Potencjał protokołu MCP tkwi nie tylko w jego specyfikacji, ale w praktycznym ekosystemie dostępnych serwerów. Do najważniejszych referencyjnych serwerów należą:

-

Filesystem – serwer dający bezpieczny dostęp do systemu plików użytkownika. Umożliwia listowanie katalogów, czytanie plików, a (opcjonalnie) także ich modyfikację/zapis.

-

Sequential Thinking – serwer “metanarzędziowy”, który dostarcza modelowi umiejętność lepszego rozwiązywania złożonych zadań poprzez planowanie i ewaluację kolejnych kroków.

-

Git - serwer udostępniający narzędzia do interakcji z repozytoriami Git. Umożliwia obsługę repozytoriów poprzez czytanie, przeszukiwanie i manipulowanie nimi przy pomocy LLM.

Poza referencyjnymi serwerami, społeczność stworzyła kilkaset dodatkowych implementacji dla różnych usług i narzędzi, gromadzonych w repozytorium “awesome-mcp-servers” na GitHubie, które ma już ponad 40 tysięcy gwiazdek.

Praktyczne zastosowania MCP

MCP otwiera możliwości integracji modeli AI z różnorodnymi systemami, co przekłada się na wiele praktycznych zastosowań:

-

Agenci programistyczni z dostępem do kodu i dokumentacji - modele mogą przeglądać repozytorium, analizować kod i dokumentację firmy, a następnie generować lepsze podpowiedzi i rozwiązania.

-

Chatboty z dostępem do baz danych i API - asystenci AI mogą odpowiadać na pytania bazując na aktualnych danych z systemów firmowych, bez konieczności szkolenia modelu od nowa.

-

Automatyzacja zadań DevOps - modele mogą pomagać w diagnostyce problemów, analizie logów i zarządzaniu infrastrukturą, korzystając z narzędzi dostępnych przez MCP.

-

Tworzenie dokumentacji - asystenci mogą analizować kod źródłowy i generować dokumentację, mając dostęp do całości projektu.

Wyzwania i dobre praktyki

Pomimo licznych zalet, korzystanie z MCP wiąże się z pewnymi wyzwaniami:

Bezpieczeństwo

Korzystając z serwerów MCP należy pamiętać o ich weryfikacji - szczególnie tych pochodzących od nieznanych źródeł. W repozytorium awesome-mcp-servers oficjalne serwery są oznaczone przez emoji medalu 🎖️. Ryzyko podatności lub hackingu jest mocno zależne od pochodzenia serwera MCP.

Zarządzanie zgodą użytkownika

MCP zakłada, że każde użycie narzędzia powinno wymagać potwierdzenia użytkownika, a serwer nie powinien mieć wglądu w całość promptu bez potrzeby.

Weryfikacja logiki serwerów MCP

Zawsze warto przeanalizować kod serwera przed jego uruchomieniem na własnej maszynie, aby uniknąć potencjalnych zagrożeń bezpieczeństwa.

Podsumowanie

Model Context Protocol stanowi przełom w integracji modeli językowych z zewnętrznymi źródłami danych i narzędziami. Jego uniwersalność, otwartość i wsparcie ze strony kluczowych graczy branży AI sprawiają, że szybko staje się dominującym standardem.

MCP rozwiązuje problem fragmentacji ekosystemu wtyczek AI, umożliwiając modelom dostęp do aktualnych danych i narzędzi poprzez jednolity interfejs. Jest to podobne do roli, jaką USB odegrało w świecie sprzętu, czy HTTP w internecie - wspólny standard, który przyspiesza innowacje i ułatwia życie zarówno developerom, jak i użytkownikom końcowym.

Jako programiści, możemy korzystać z gotowych serwerów MCP lub tworzyć własne, dostosowane do specyficznych potrzeb naszych projektów. Niezależnie od wyboru, warto śledzić rozwój tego ekosystemu, ponieważ MCP otwiera nowe możliwości dla tworzenia inteligentnych, kontekstowych aplikacji AI. To również dowód na rosnącą dojrzałość całego ekosystemu - powszechnie akceptowane praktyki i protokoły powodują, że z punktu widzenia użytkownika możemy się wreszcie skupić na tworzeniu wartości biznesowej i bardziej zaawansowanych funkcjonalności opartych na AI.

Naucz się tworzyć własne serwery MCP

Już wkrótce rusza druga edycja flagowego szkolenia 10xdevs.pl, gdzie nauczysz się tworzyć własne serwery MCP i integrować je z LLMami. Dołącz na listę oczekujących i nie przegap premiery!