Apple Intelligence, czyli co pokazało Apple na WWDC 2024

TL;DR

Apple wskakuje do pociągu o nazwie Generatywna Sztuczna Inteligencja. Zestaw rozszerzeń o nazwie “Apple Intelligence” zaprezentowany na konferencji WWDC pokazuje, że na naszych oczach odbywa się jedna z największych transformacji oprogramowania konsumenckiego.

Siri z ChatemGPT - nowa jakość asystenta Apple

Długo na to czekaliśmy, ale w końcu potwierdziło się - Apple wskakuje do pociągu o nazwie Generatywna Sztuczna Inteligencja. Zestaw rozszerzeń o nazwie “Apple Intelligence” zaprezentowany na konferencji WWDC pokazuje, że na naszych oczach odbywa się jedna z największych transformacji oprogramowania konsumenckiego, jakich mogliśmy doświadczyć przez ostatnie 20 lat.

Własne reguły gry

Agenda wydarzenia udowodniła, że na poziomie komunikacji Apple nie ugina się pod presją rynku. Chociaż już wcześniej dało się wyczuć, co będzie głównym tematem sesji otwierającej WWDC 2024, pierwszą godzinę rozegrano na własnych zasadach. Systemy operacyjne visionOS, iOS, iPadOS a także macOS były tymi, od których zaczął się przegląd nowości na sezon 2024/2025.

Nieprzypadkowo to właśnie visionOS 2 był tym, od którego rozpoczęto całą prezentację. Nowy system operacyjny pod tzw. “spatial computing”, czyli rozwiązania AR/VR, będzie konsekwentnie wchodził w buty iOS i macOS, przygotowując Apple na rozwój zupełnie nowej linii produktowej. Wyniki sprzedażowe pierwszej generacji Vision Pro nie zachwycają, ale znajdujemy się na początku cyklu życia tego urządzenia. Zapowiedziane rozszerzenia dotyczą m.in. nowych SDK dla programistów, kolejnych gestów czy możliwości rozszerzania ekranu MacBooka na dwa monitory 4k. Brakuje tylko ekosystemu aplikacji, ale Apple chwali się “1.5mln kompatybilnych aplikacji” - na dzisiaj to niestety trick bazujący na portowaniu rozwiązań z iOS / iPadOS. W tej części warto jeszcze docenić dostępność flagowych gogli VR, które już od tego lata będą dostępne w 8 krajach, w tym w Niemczech - Vision Pro na OLX is coming.

Po rozszerzonej rzeczywistości przyszedł czas na core linii produktowej Apple, czyli platformy iOS, iPadOS oraz macOS. Tutaj istotną nowością jest odpowiedź na Material You, czyli personalizowany Design System od Google. Systemy z jabłkiem w logo otwierają się na możliwość dowolnego układu ikon na pulpicie, zmiany kolorystyki, ukrywanie etykiet aplikacji a także dostosowywanie tzw. Control Center. Użytkownicy Androida, na którym to wszystko było dostępne od kilku lat, mogą się wyłącznie uśmiechać, a ja mam pewne obawy co do utraty spójności UI/UX z której zawsze znane było Apple.

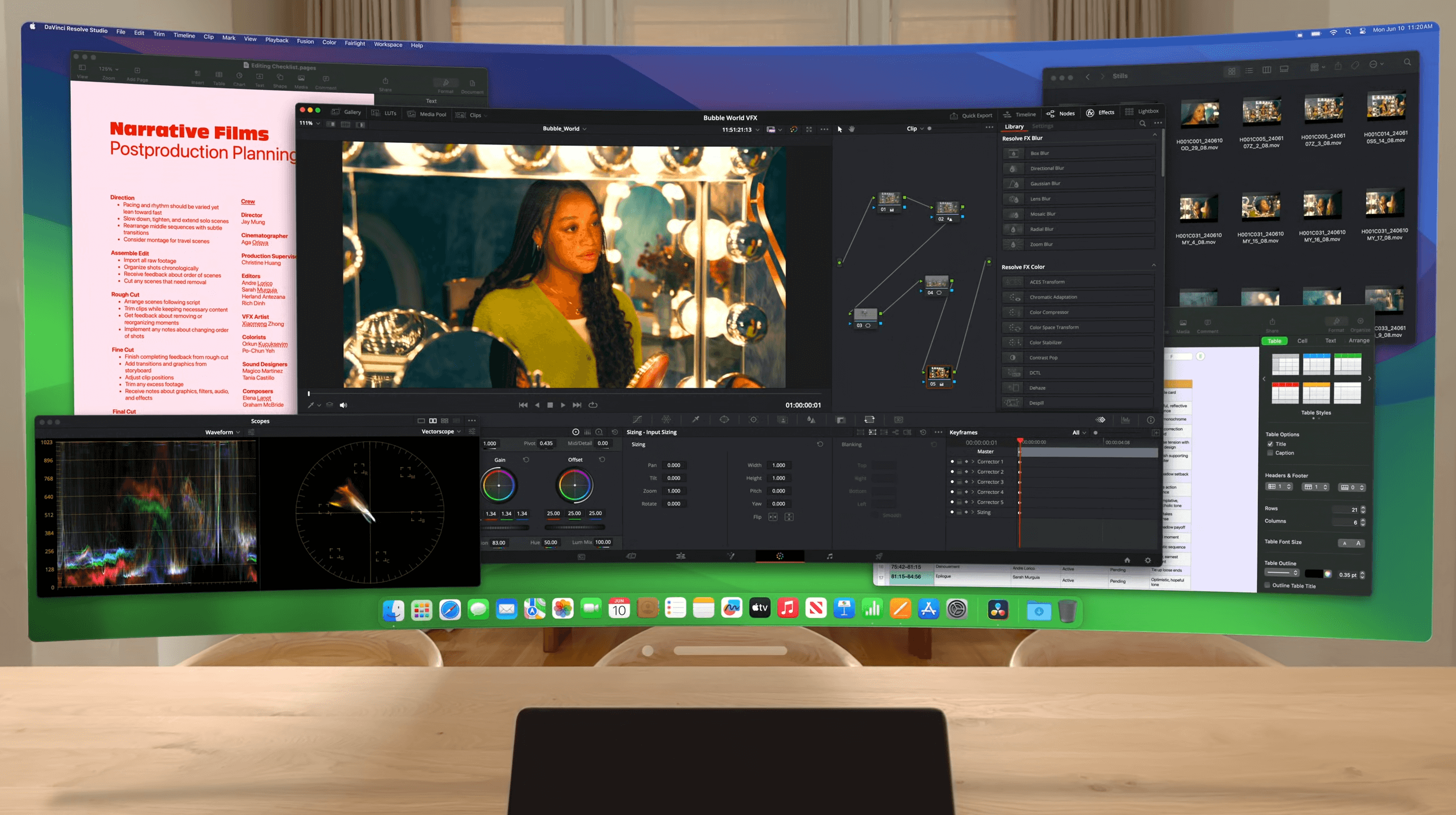

Zmianą na plus w mojej ocenie jest możliwość “mirroringu” iPhone’a na Maku, np. celem łatwiejszego testowania aplikacji w trybie developerskim lub pracy z aplikacjami mobilnymi przy pomocy myszki i klawiatury. Nie jest to zupełny gamechanger, ale rozwiązanie natywne będzie darmowe, no i zapewne bardziej stabilne i przewidywalne, niż zewnętrzne aplikacje.

Gwiazda wieczoru - Apple Intelligence

Po przejściu przez wszystkie najważniejsze systemy operacyjne nadszedł czas na gwiazdę wieczoru. Tą miała być Sztuczna Inteligencja, chociaż “sztuczna” w marketingowym słowniku Apple to słowo zakazane. Firma wymyśliła więc swój własny brand o nazwie “Apple Intelligence”. Trzeba przyznać, w tej grze są po prostu najlepsi.

No dobrze, a czym to Apple Intelligence tak właściwie jest? Wg liderów Apple, którzy wprowadzali nas do całej tematyki, to sposób na nadanie osobistego kontekstu całemu oprogramowaniu. O ile epoka “pre-AI” miała się skupiać na spójnych rozwiązaniach w ramach jednego ekosystemu, tak “AI” ma wszystkim procesom nadać kontekst personalny - związany z tobą, twoimi kontaktami, aplikacjami, no i akcjami, które chcesz realizować w łatwiejszy sposób.

Niby marketing, ale ten sposób komunikacji dobrze pokazuje, jak Apple podchodzi do tematu AI. Po pierwsze, nie “sztuczna”, a osobista inteligencja, po drugie nie sieci neuronowe, parametry czy modele językowe, a oprogramowanie osobiste. Odbiorcą ma być każdy użytkownik ich sprzętu, a nie - jak w przypadku innych firm - pasjonat LLMów.

Apple zaznacza, że AI ma działać w oparciu o 5 fundamentalnych zasad, które przedstawiono w trakcie WWDC:

- Powerful

- Intuitive

- Integrated

- Personal

- Private

Konsekwencją takiego ustawienia priorytetów jest fakt, że AI nie jest przystawką do reszty systemu ani osobną aplikacją w stylu ChataGPT, a przekrojowym zestawem rozszerzeń działających na poziomie systemu operacyjnego.

Przykładowo, Siri ma od teraz działać w sposób multimodalny - tj. oparty o to, co użytkownik widzi na ekranie, oraz jakie polecenia w tym kontekście wydaje. Jest to istotna zmiana w porównaniu do obecnej wersji asystenta, który reagował na proste i (szczególnie w Polsce) ograniczone polecenia głosowe.

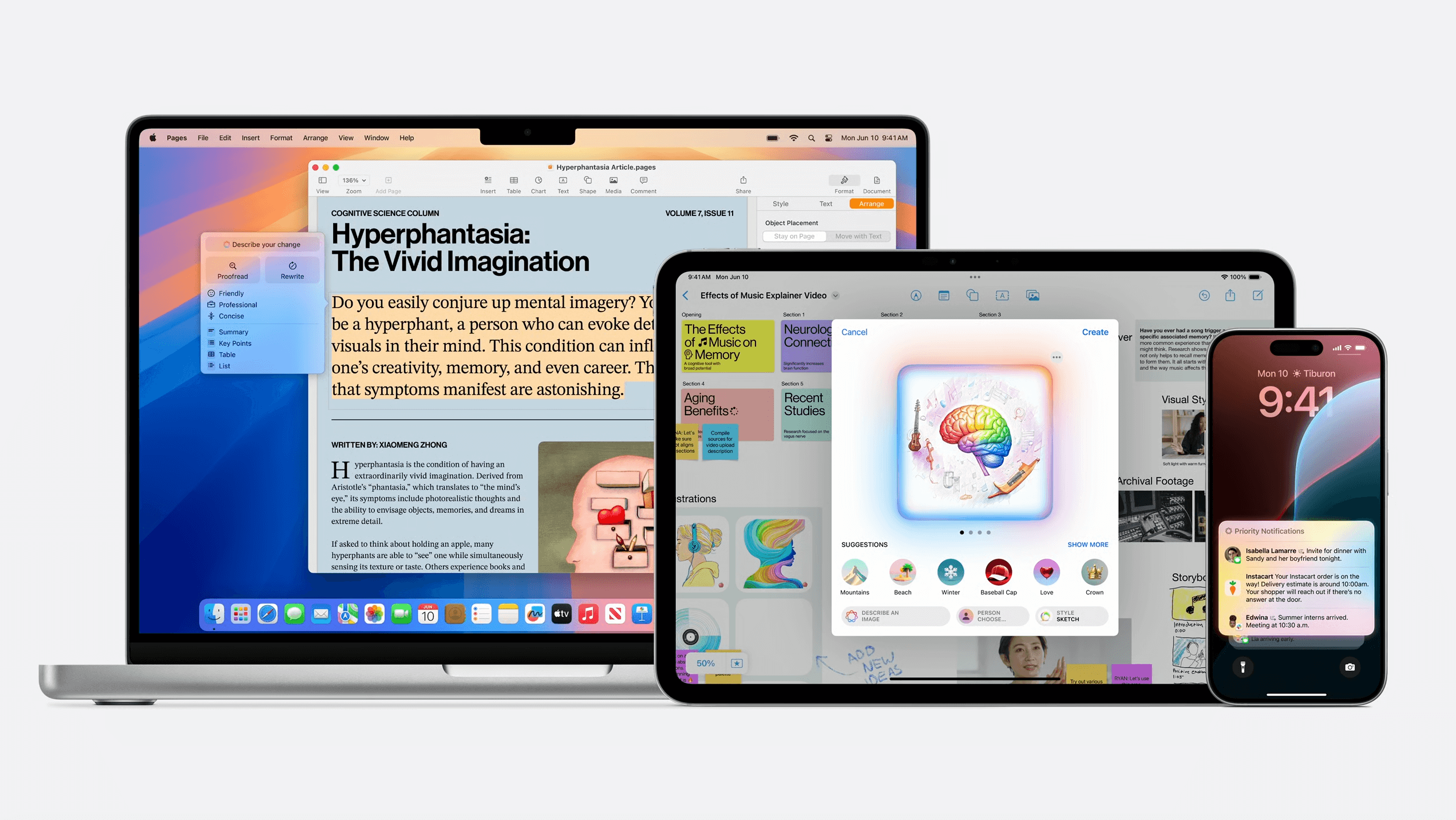

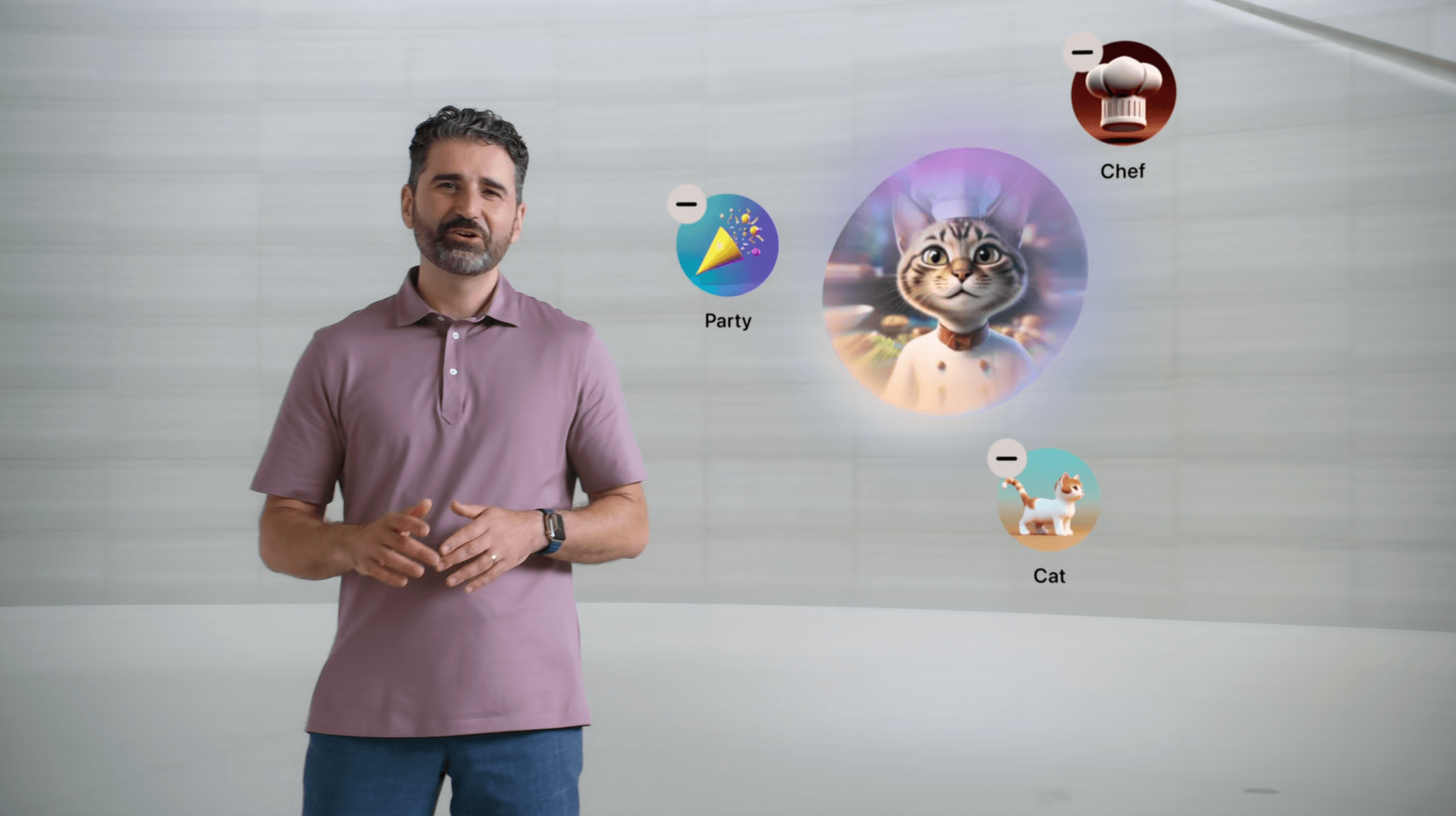

Rozszerzenia AI zobaczymy w kilku obszarach - na poziomie tekstu Apple pracuje nad usługą “Rewrite”, która poprawi lub zmieni ton słów wprowadzonych do dowolnej aplikacji. W obszarze grafiki nowości zobaczymy m.in. w Zdjęciach, generowanych na żądanie emoji oraz ilustracjach tworzonych w odpowiedniku Midjourney o nazwie Image Playground. Dla mniej zaawansowanego użytkownika ciekawym dodatkiem powinna być również wbudowana dokumentacja produktowa, dzięki której Siri pomoże nam poruszać się po systemie, skonfigurować interfejs czy zarządzać urządzeniami zdalnymi.

Kluczowy deal z OpenAI

Przed konferencją mówiło się, że dla Apple opisywana prezentacja to będzie “make it or break it” - analitycy wskazywali, że firma przespała rosnący potencjał modeli językowych takich jak GPT-2 i GPT-3.5, przez co teraz musiała ratować się rozwiązaniami zewnętrznymi. No i znalazła rozwiązanie.

W trakcie wydarzenia okazało się, że wizyta Sama Altmana w Apple Park nie była przypadkowa. CEO OpenAI nie zabłądził, nie zapomniał adresu do własnego biura, nie wpadł również na kawę, ale pojawił się w roli dostawcy brakującego elementu całej układanki - modelu state-of-the-art, czyli GPT-4o, którego na dzisiaj Apple nie potrafi dogonić.

Jak wygląda architektura całego “Apple Intelligence” w kontekście integracji z zewnętrznymi modelami? Apple wspomina, się ich usługi będą od teraz wykorzystywać mieszankę trzech rozwiązań - modeli lokalnych, działających na urządzeniu (SLM, 3B parametrów), modeli zdalnych, działających na chmurze Apple, a także usług zewnętrznych dla najbardziej zaawansowanych scenariuszy.

Z opublikowanych informacji wynika, że Siri będzie od teraz wykorzystywać koła ratunkowe w postaci zewnętrznych modeli takich jak GPT-4o i usług pokroju ChataGPT wszędzie tam, gdzie zadanie przerośnie jej możliwości. Z punktu widzenia użytkownika cały proces będzie transparentny - to my będziemy decydować czy zapytanie opuści nasze urządzenie, a odpowiedź będzie generowana poprzez ChatGPT. Będzie to jednak wersja darmowa - do przejścia na wersję Plus będzie nam potrzebna prywatna, niezależna subskrypcja.

Co ciekawe, Apple nie zamyka się na OpenAI wspominając, że w przyszłości chętnie widzieliby na pokładzie Google Gemini i jego alternatywy. Widać więc, że firma traktuje AI jako dodatek do usług rozwijanych przez ostatnie dekady, a nie nowy, rewolucyjny core swojej działalności.

Prawie idealnie

Prezentacja “Apple Intelligence” była naprawdę intensywna, chociaż moim zdaniem przed inżynierami jeszcze sporo pracy nad ostateczną formą całego rozwiązania.

Po pierwsze, interfejs użytkownika. Apple od zawsze słynęło z wypolerowanych rozwiązań na poziomie UI. Ich systemy były nieco bardziej zamknięte od konkurencji, ale dzięki temu “Apple vibes” dało się wyczuć na kilometr. Aplikacje wyglądały podobnie względem siebie i trudno było pobrać z AppStore coś, co nie nadawało się pracy. Teraz, przy zupełnej dowolności modyfikacji pulpitu oraz nie do końca gotowej edycji kolorów ikon całość wygląda mocno średnio. Dokładając do tego rozszerzenia AI, w tym nowe animacje, pola tekstowe, ikony oraz nakładki na istniejący system, zauważyłem pierwsze oznaki projektowego Frankensteina.

Po drugie - wsparcie urządzeń. Niestety, Apple Intelligence to rozwiązanie, które pojawi się na urządzeniach mobilnych z procesorami A17 i nowszych (czyli tylko iPhone 15 Pro z 2023!) oraz urządzeniach desktopowych i tabletach z M1+. Szczególnie źli mogą być użytkownicy poprzedniej generacji smartfonów (zaledwie z końcówki 2022r.) którzy zostali wykluczeni z grona odbiorców nowego Siri.

Po trzecie - języki. Apple wspomina, że AI pojawi się jako beta na jesieni tego roku, ale wyłącznie na urządzeniach ustawionych pod “U.S. English”. Zakładam, że to jasna odpowiedź dla tych, którzy oczekiwali polskiego Siri - jeszcze nie teraz, jeszcze nie w tym roku.

Przy tych dość istotnych ograniczeniach warto jednak docenić pomysł Apple na AI. Jest to zdecydowanie bardziej przystępne i mniej nacechowane technicznym żargonem wdrożenie, gdzie użytkownik nie musi znać pojęć takich jak “prompting”, “model językowy” czy “parametry”. Dla typowego użytkownika Apple, AI będzie formą “magii” - odręczne obliczenia w kalkulatorze będą rozwiązywać się same, obrazy będą generowane z avatarów kontaktów czy szkiców z notatek, a odpowiadanie na maile przyśpieszy dzięki automatycznemu uzupełnianiu treści. To mocny sygnał dla całej branży - AI nie musi być w centrum uwagi, aby zmieniać nasze życie na lepsze.

Czy AI wywoła masowe zwolnienia w programowaniu? Zapisz się na darmowy webinar i zobacz jak dostosować się do epoki generatywnej sztucznej inteligencji. Wydarzenie szczególnie polecamy frontend developerom, którzy rzekomo stoją na początku kolejki do utraty pracy.